Netpeak Spider — удобный инструмент оптимизатора ОТМЕНЕНО!

Обновление 03.03.2022. Сейчас Российская федерация, взвалившая на себя вторично — после Великой Отечественной войны — груз ответственности за освобождение соседней Украины от нацизма в его нынешнем, пусть и современном, но не менее страшном обличье откровенного фашизма.

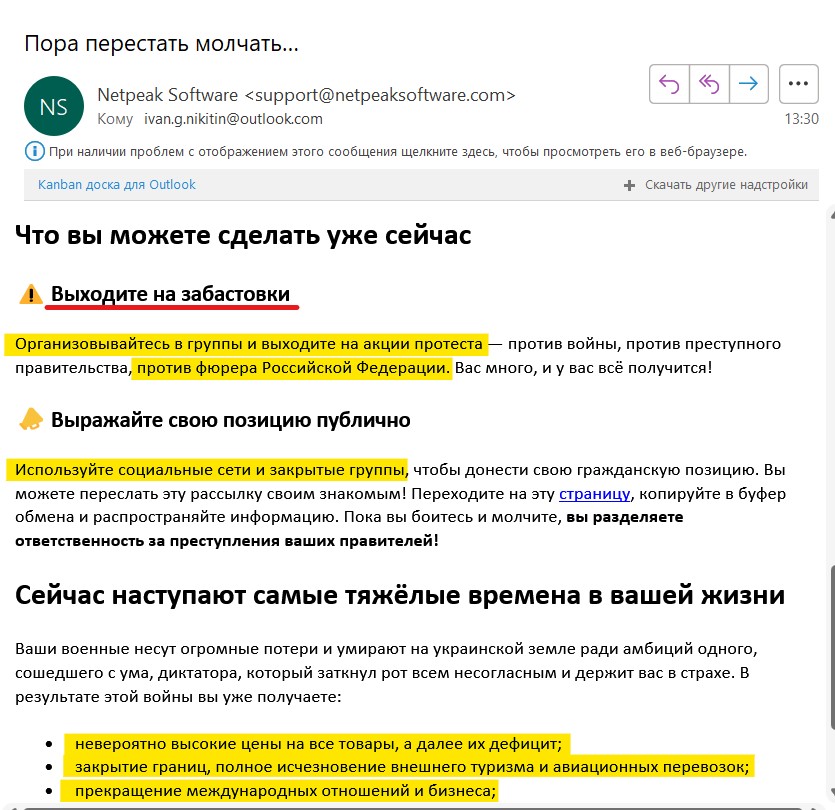

В этот тяжелый час далеко не все представители бизнеса ведут себя адекватно. Мы выражаем глубокое сожаление что известная компания NetPeak скатилась в своей истерике до откровенной лжи, гебельсовской пропаганды и прямым призывам к нарушениям законов России.

Я категорически не одобряю такие выходки, поэтому с сегодняшнего дня использование и оплата любых продуктов NetPeak в нашей компании ЗАПРЕЩЕНО! Надеюсь, что фашиствующих пиарщиков из Харькова постигнет та же участь, что и полицаев после Великой Отечественной Войны.

Пропаганда и призывы к нарушению конституции РФ в письме NetPeak

Добрый день!

Скажите, этой программой можно проверить любой сайт, в том числе и конкурентов, или ей необходим какой-то особый доступ к серверу?

Полина, проверить можно любой сайт. Единственное, кажется, если сайт закрыт от индексирования, то нет пик не сканит.

Здравствуйте. Подскажите, пожалуйста. Перенесла блог с купленного домена на бесплатный на Блоггере. Проверила Netpeak Spider. Показал в числе прочих критичных ошибок 20% висячих узлов. Насколько поняла, это связано с тем, что, помимо постоянной ссылки, каждый пост имеет поисковую ссылку через ярлыки (которые присваиваются каждому посту вручную). Как исправить сие?

С уважением, Елена.

Нет, это говорит о том, что ряд страниц не имеют исходящих ссылок. Вот определние:

PageRank: висячий узел → как было указано выше, это страницы без исходящих ссылок, которые не пропускают ссылочный вес, нарушая тем самым естественное распределение ссылочного веса по сайту.

Вот подробности: https://netpeaksoftware.com/ru/blog/netpeak-spider-2-1-1-2-raschyot-vnutrennego-pagerank

Исправляется перелинковкой на сайте: автоматической — продумыванием хлебных крошек, связанных записей и т.п. или ручной — на этих страницах ставятся ссылки на самые важные другие страницы сайта.

Спасибо за оперативность и информативность! )

Т.е. то, что каждый пост имеет разные адреса (в зависимости от того, как на него попал — из содержания блога или через ярлыки ) — это нормально?

Да, это нормально.